- 1. Pythonの分析モデルをBYOMしてVantageで利用する

- 2. python: wordcloud テキストを可視化しましょう。ギャルバースの説明文は絵になります

- 3. Pythonで人工衛星画像を扱う:Sentinel Hub APIのコードを作成して、衛星画像をダウンロードしましょう

- 4. Fletを試す(5) – Cloudflare Pages にデプロイする

- 5. Pythonの依存パッケージとダウンロード先URL一覧をゲットする方法

- 6. 「Point-E」 3Dモデルを作成するAI PythonのCollabでやってみましょう。AIで3Dモデルは本当に作成できるか?

- 7. Opencv2-python: fillPoly() jsonのファイルからマスクを作成する方法

- 8. python: requests.get() ネットからjsonのデータを読み込み

- 9. AWS SAMのローカル開発でホットリロードを効かせる

- 10. OpenCV-python:リサイズする方法(cv2.resize)

- 11. [実装メモ] OpenBanditPipelineで、自分で用意したログを使う

- 12. AWS SAMとHugging Face Transformersでサーバーレスな推論APIを作る

- 13. 【Python】Deep Learning 向け動画読み込みライブラリ「decord」

- 14. Pythonでの音声信号処理 (9) 波の解析の一歩の疑問点

- 15. 初心者がDjangoを勉強したのでざっくりとアウトプットします

- 16. 【自動化】pyautoguiでクリックマクロ

- 17. Blenderでモーションを線形補間して120fpsデータに変換するスクリプト

- 18. [Python]ローカルのファルダ内にあるHTMLソースファイルの全リンクを抽出

- 19. Tools to do research more efficiently

- 20. BERTで自殺ツイートを検出する試み ~③ナイーブベイズでの判別~

Pythonの分析モデルをBYOMしてVantageで利用する

こんにちは

今回は Pythonで作成した分析モデルをVantageで活用する方法について解説したいと思います。

使いなれたPythonで分析モデルを作成頂き Vantageにインポートして頂く事で Vantage内にあるデータを高速にスコアリングする事が可能です。

::: note

この記事は**Teradata Vantage**と**Teradataml**を使用して**Pyhton**で作成した分析モデルを**BYOM**(Bring Your Own Meeting)してVantageにインポートする事で業務に活用する流れを説明します。

Vantage の BYOM は 現在 **PMML, ONNX, H2O MOJO フォーマット**に対応しています。

:::# はじめに

使用するデータは scikit-learnの機械学習

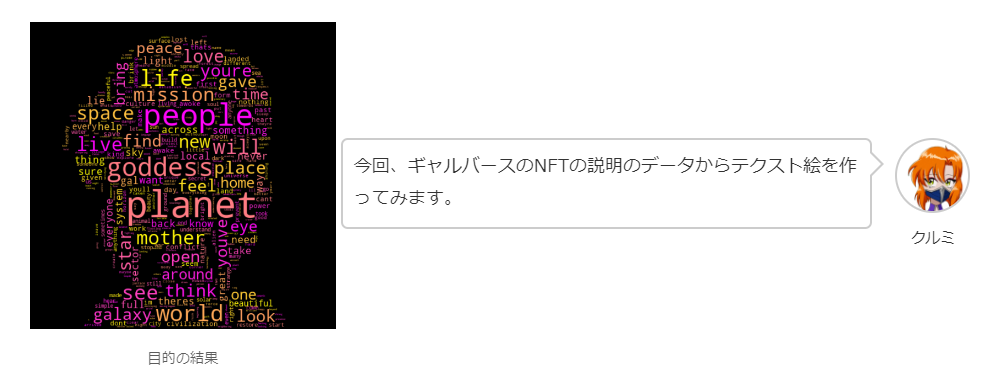

python: wordcloud テキストを可視化しましょう。ギャルバースの説明文は絵になります

PythonでWordcloudというモジュールを利用したら、文字やテクストは綺麗な絵になります。データ可視化はとても大事なスキルですね。今回、ギャルバースのNFTの説明文から絵を作ります。

データがない場合は、この[リンク](https://drive.google.com/file/d/1-19NWWHfCPF9GNUA15s0vlx8sL0TcGvp/view)からダウンロードしてください。そして、コードはすべて[Colabのノートブック](https://colab.research.google.com/drive/13wm2ID2X-k2gSyE7Lcfx9aopiyBp7Z5m?usp=sharing)で共有しています。# データのセットアップ

最初にwordcloudをインストールします。“`

!pip install

Pythonで人工衛星画像を扱う:Sentinel Hub APIのコードを作成して、衛星画像をダウンロードしましょう

# イントロ

今回の記事には、SentinalというのESA(欧州宇宙機関)の人工衛星の画像を取得して、イギリスのKeyGardens(キューガーデン)を表示してみます。すべてのコードはcolabとgithubでアップしましたので、ぜひ使ってください

([Colabのリンク](https://colab.research.google.com/drive/1a1dU4hRnfp5JG8jAvgLVUdmvp1wbpWwT?usp=sharing) [Githubのリンク](https://github.com/JarvisSan22/Jinlabs_learn_python_Notebooks))

– Cloudflare Pages にデプロイする

# はじめに

PythonでFlutterアプリが作れるフレームワーク「Flet」の検証です。

2023/2/6あたりに、Fletがv0.4.0になりました。

その後、公式のドキュメントに「Deploy a static website to any free hosting such as GitHub Pages, Cloudflare Pages or Vercel!」というとで、静的WebサイトとしてFletアプリをデプロイできるという記載が追加されましたので、試してみました。https://flet.dev/docs/guides/python/publishing-static-website#deploying-website

今回は、使ったことがある Cloudflare を試してその結果をまとました。

実際にデプロイしたものが↓。

https://flet-report01.pages.dev/

制限はありますが、Fletアプリを無料で公開できます。# 前提事項

– 試した環境

– Windows10

– Python 3.11.1

Pythonの依存パッケージとダウンロード先URL一覧をゲットする方法

# はじめに

仕事で Python パッケージの依存パッケージ一覧と、そのパッケージのダウンロード先URL一覧が必要になったのですが、取り出す方法がなかなか見つからなかったので、(もっといい方法がありそうですが…) 方法をメモします。

例として Python 3.8 の pandas の場合、依存パッケージは下記で

“`

numpy==1.24.2

pandas==1.5.3

python-dateutil==2.8.2

pytz==2022.7.1

six==1.16.0

“`ダウンロード先は下のようになりました。

“`

https://files.pythonhosted.org/packages/bf/8c/3d36cef521739bd481e9a5b30e5c0f9faf8b7fe7b904238368908a9d149d/numpy-1.24.2-cp38-cp38-win_amd64.whl

https://files.pythonhosted.org/packages/ca/4e/d18db7d5ff9d28264cd2a7e2499b870110

「Point-E」 3Dモデルを作成するAI PythonのCollabでやってみましょう。AIで3Dモデルは本当に作成できるか?

# イントロ

Openaiは12月に[「point-e」のGithub](https://github.com/openai/point-e)を公開されて、テクストや2D画像から1~2分で3Dモデルを作成できます。

今回の記事のコードはすべてCollab内で利用

Opencv2-python: fillPoly() jsonのファイルからマスクを作成する方法

# 概念

“`python

cv2.fillPoly(img,polygon_coord,fill_val)

“`

引数

img: (画像)np.array

polygon_coord: ポリゴンの座標 x,y のnp.array [[x1,y1],[x2,y2]…..] intの値

fii_val: 塗りつぶす値 (値と色のarray)画像内でポリゴンの範囲を塗りつぶします。物体検出やポリゴンのデータからマスクを作成することでよく利用している関数です。

polygon_coordsは (1,p,2)のサイズのnp.arrayです。pはポリゴンのポイントです。画像内で塗りつぶすので、polygon_coords形式はintが必要です。# jsonからマスク作成

画像セグメンテーションのタスクでは、もとデータはよくjson形式です。モデル内で読み込むために、画像のarrayに変換しなければなりません。このjsonのデータは、xyのarrayに変化して、cv2.fillpollyを利用したら、画像に変換できます。

今回、[cv2.resize()](https://qii

python: requests.get() ネットからjsonのデータを読み込み

# 概念

“`python

requests.get(url,header)

“`

引数

url : ダウンロードしたいファイルの保存先

header: 送信する内容を辞書requestsとはHTTP通信を扱うモジュールです。ウェブサイトからダウンロードをダウンロードしたいなら、requests内の関数 getを利用します。

requests.get()の結果は「.json()」と加えると、jsonのファイルを直接に読み込みます。とても便利なツールです。# Sample Code サンプルコード

コードはすべてGithubで保存しています。自分のpython環境とGoogleColabで使ってみてください [リンク](https://github.com/JarvisSan22/Jinlabs_learn_python_Notebo

AWS SAMのローカル開発でホットリロードを効かせる

# やりたいこと

`sam local start-api`コマンドなどでAWS SAMをローカル環境で動かしている再、ソースコードを変更してもホットリロードで変更が反映されません。変更を反映するには`sam build`を実行しなければいけません。

`sam local start-api`を実行しているターミナルとは別のターミナルで`sam build`を実行すればビルド後のファイルを自動で読み込んではくれます。

これを利用してVSCodeの拡張機能「[Run on Save](https://marketplace.visualstudio.com/items?itemName=emeraldwalk.RunOnSave)」を使ってファイルを保存したら`sam build`が走るようにすることでホットリロードっぽい挙動を実現してみました。

# やりかた

拡張機能をインストール後

例えばPythonのプロジェクトならこのように設定をしておきます。“`json:.vscode/setting.json

{

“emeraldwalk.runonsave”: {

OpenCV-python:リサイズする方法(cv2.resize)

# 概要

“`python

cv2.resize(img, Size,fx=0,fy=0,interpolation=INTER_LINEAR)

“`

・img: ndarray

・Size: (w,h) サイズの大きさ

・fx x方法の倍率

・fy y方法の倍率

・interpolation: リサイズの処理方法cv2.resizeはリサイズするために二つの方法が含んでいます。最初にSizeです。希望のサイズを設定して (例え、(256,256) )、画像はこのサイズへ変換します。二つ目の方法は、fxとfyの倍率の方法です。最初に SizeはNoneと設定して、fxとfyのfloatの値により、リサイズを行います。

# Sample Code サンプルコード

“`python

import matplotlib.pyplot as plt

import cv2

img=cv2.imread(“doge.jpg”)[:,:,::-1]

#Resize D Size

img_ds=cv2.resize(img,(500,300)) # ( X, Y)

#Resize

[実装メモ] OpenBanditPipelineで、自分で用意したログを使う

# 概要

OPEを簡単に実行できるPythonライブラリ、「OpenBanditPipeline」の使い方を1つ検討してたので、メモを残します。https://techblog.zozo.com/entry/openbanditproject

https://github.com/st-tech/zr-obp

上の記事などで紹介される実装では、基本的にOpenBanditDataset(zozoのオープンデータ)かSyntheticBanditDataset(シミュレーション作成したデータ)を使う方法で実装されています。

しかし、私がやりたいことは、「自分で用意した任意のログに対してバンディットのシミュレーションし、OPEを算出したい」という内容です。

そこで、OpenBanditDatasetもSyntheticBanditDatasetも使わずに、自分の定義したデータを既存ポリシーとして利用する方法を検討しました。# bandit_feedbackを定義する関数

OpenBanditDatasetやSyntheticBanditDatasetでデータを作成すると、「

AWS SAMとHugging Face Transformersでサーバーレスな推論APIを作る

# 作ったもの

[Hugging Face AutoTrain](https://huggingface.co/autotrain)を使って、テキストの二値分類をする機械学習モデルを作ったので、それをAWS SAMでデプロイしてみました。

↓のような形でPOSTできて、推論結果などを返してくれます。“`bash

❯ curl -X POST -H “Content-Type: application/json” -d ‘{“text”:”テストだよ”}’ https://xxxx.lambda-url.ap-northeast-1.on.aws/

{“label”: 0, “message”: “success”}

“`なお、Lambda関数をAPIとして使うにはAPI Gateway経由で呼び出すのが鉄板ですが、やってみたらAPI Gatewayの30秒制限に引っかかった(※)ので、今回は[Lambda Function URL](https://docs.aws.amazon.com/ja_jp/lambda/latest/dg/lambda-urls.html)とい

【Python】Deep Learning 向け動画読み込みライブラリ「decord」

# その名は「decord」です

https://github.com/dmlc/decord/tree/v0.6.0

`decord`はハードウェアアクセラレーションによるビデオデコーダーの上に、薄いラッパーに基づいた便利なビデオスライスの方法を提供します。

2023/2/9時点ではバージョン0.6.0で、pythonのバージョン等に制限があります。

– [M1 mac 使用不可。](https://github.com/dmlc/decord/issues/240)

– [Mac ではpython3.5~3.8のみ対応。](https://github.com/dmlc/decord/issues/213)などなど、開発中の不具合も多いみたいです。ですが読み込みは非常に高速で今後に期待できます。

“`pytho

Pythonでの音声信号処理 (9) 波の解析の一歩の疑問点

## 今回のテーマ

「(8) 波の解析の一歩」を踏まえて、しっくりこない疑問点を整理する。疑問点

1. sin波が横にズレたような場合に、解析結果が変にならないか

2. そもそも周期が分からないときはどうすればいいか順番に検証する。

### 「sin波が横にズレる」場合

「sin波が横にズレる」とは、つまり、

のように、dだけズレたような場合でも、きちんと周波数成分を抽出できるのかということ。dだけズレたsin波の式を加法定理を使って展開すると、

という感じになる。つまり、同じ周波数の

初心者がDjangoを勉強したのでざっくりとアウトプットします

# Djangoとは

Djangoとはウェブアプリケーションを作る手助けをしてくれるフレームワークのことです。Djangoを用いることで、より安全に、より効率的にウェブサイトを作成することができます。

一般的なウェブサイトではブラウザから表示したいURLをサーバーにリクエストし、サーバーはそれに対応するファイルをブラウザにレスポンスとして返します。

一方、Djangoではリクエストを受け取ったあとサーバー内で処理を行った後に、レスポンスを返します。これにより、使うデータを指定できたり、見た目を変更したりすることができます。要するに、より便利なサイトを提供することが可能になるということです。# Djangoの構成

Djangoは以下の3つから構成されています。– Controller

`Model`に使うデータを指示したり、`View`に使うテンプレートを指示する。– Model

`View`にデータを受け渡す。– View

テンプレートとデータを組み合わせた情報を`Controller`に渡す。

以下、それぞれを実際にどう使うかを説明します。## Co

【自動化】pyautoguiでクリックマクロ

## 1.はじめに

何か悪いことをしたい人のために、記録を残しておきます。## 2.必要な知識

・Python(ループとか分岐とか使って好きに組める)

・pyautoguiのインストール

・threadingの使い方とか

・Windowsのスクショツールの使い方## 3.研究概要?

5年前ぐらいに挫折したプログラムを再度作り直してみました。

プログラムの中身を公開するというよりは、作り方のヒントをまとめます。## 4.作り方のヒント

### あくまでヒントです。組み立ててオリジナルマクロを作ろう!

##### まずはライブラリのインポート

“`python

import pyautogui as pag

import random as rand

import time

import threading

“`##### クリックする関数

引数のiconには何をクリックしたいかを渡すわけです。

そうすると、保存してある画像を読み込んで、その範囲内でランダムにクリックしてくれます。

__正直、これを動かすだけでもかなり楽しい。__

“`pyth

Blenderでモーションを線形補間して120fpsデータに変換するスクリプト

# 内容

モーションをより高いフレームレートにしたいとき、フレームごとのデータを編集する必要がありますが、そのためのコードと説明です。

Blenderではアニメーションデータをキーフレームから編集する方法が一般的らしいですが、内部のデータを扱うのは面倒なので、ボーンデータを編集して線形補間後のモーションを作成します。# Blenderのボーンの種類

### Bone

Objectモードのボーン。**Read Only**なので、名前の変更やボーンの追加、削除ができません。

### EditBone

Editモードのボーン。**名前の変更やボーンの追加、削除ができます**が、フレームごとのデータ編集はできません。

### PoseBone

Poseモードのボーン。**フレームごとのデータ編集**ができます。今回はフレームデータを編集するので、**PoseBone**を使用します。

# ボーン内のデータの種類

### 平行移動

– xyzの3次元ベクトルでそれぞれの軸の平行移動を表します

– 補間方法は**線形補間**

– PoseBone.lo

[Python]ローカルのファルダ内にあるHTMLソースファイルの全リンクを抽出

## 経緯

https://qiita.com/akira-hagi/items/749f70127ee1d4fa4206ほぼ前回の続きです

webページのソースをディレクトリそのままにスクレイピング、詳しく述べると、

`https://www.hoge.com/huga/hoge/index.html`と`https://www.hoge.com/huga/index.html`のソースをまとめて取得するとき、

ドメイン名をトップディレクトリとし、

“`

└── www.hoge.com

└── huga

├── hoge ── index.html

└── index.html

“`

のようにしてローカルに持ってきましたこのHTMLソース群の中からリンク(aタグのhref要素やimgタグのsrc要素など)を抽出したいと考えました

~~スクレイピングする時にわざわざソースをローカルに落とさずに直で抽出すればいいじゃんというツッコミは無しでお願いします~~## とりあえず思いつくままに書く

“`python

fr

Tools to do research more efficiently

– ## General

– ### ChatGPT

– Interactive AI: code generation, correction and improvement of sentences, planning for a trip, writing a story

– https://chat.openai.com/auth/login

–

– ## Note

– ### Logseq

– A notepad that remembers and visualizes information connections

– [https://note.com/sangmin/n/n29ad21d537cc](https://note.com/sangmin/n/n29ad21d537cc)

– https://logseq.com/

–

– ## Search

– ### Perplexity Ask

– Interactive search engine, reliable citations

– [https://t

BERTで自殺ツイートを検出する試み ~③ナイーブベイズでの判別~

# はじめに

皆さんこんにちは。今回はナイーブベイズにて自殺ツイートを判別できるか試してみます。

データセット作成とEDA、ルールベースでの検出の流れは下記をご参照ください。https://qiita.com/harunan0913/items/a1081abc593d7248b22a

https://qiita.com/harunan0913/items/b8d6a7414898e691da40

# その前にワードクラウドを描いてみる

自殺ツイートと無関係なツイートの特徴の違いを見るためにワードクラウドを描いてみます。janomeでトークナイズした後、ワードクラウドを描きます。

“`Python

!pip install janome

!pip install demojifrom pprint import pprint

import re

import demoji

from janome.tokenizer import Tokenizer

import collections

%matplotlib inline

from wordcloud import Wo