- 1. AWS Lambda から Power Automate の Teams Incoming Webhook コネクタの挙動をテストする

- 2. AWS-Parameters-and-Secrets-Lambda-Extensionを試す

- 3. AWS API GatewayでLambdaプロキシ統合を設定する方法

- 4. AWS Lambda上で「LINE Messaging API SDK for Python」を使ったコードをデプロイしてLINE Botを作ることを楽しむ

- 5. Lineでよさそうな部屋を紹介してくれるボットを作成する

- 6. AWS LambdaでSupabaseを使用したらNo module named ‘pydantic_core._pydantic_core’が出た時の対処

- 7. タグベースによるEC2インスタンスの夜間停止によるコスト削減

- 8. akippaの予約CSVからGoogleカレンダーに転記するLambda関数 #2

- 9. AWS Lambdaで翻訳APIを作成するハンズオンをやってみた

- 10. 「RDSデータを長期的に格納」RDSからS3にスナップショットを自動的に輸出

- 11. Backlog Gitリポジトリの更新をトリガーに、Amazon S3にコンテンツを自動でアップロードする

- 12. AWS CDKでCloudfront – Lambda FunctionURLsのOACを定義する

- 13. VPCを設定したLambdaからインターネットにアクセスしたい

- 14. Autonomous Database:S3にファイルがアップロードされたらすぐに表にロードし、ロード完了後にS3上のファイルを削除する

- 15. 【AWS SAM】入門してみた dockerで環境構築 ruby

- 16. Python lambdaで一行関数を書く時のコツ

- 17. Lambda関数で日本語ファイルを処理する際にエラーが出た

- 18. Lambda関数でAWS CLIを使用する

- 19. AWS CDKを用いてRemixアプリケーションをLambdaにデプロイする

- 20. akippaの予約CSVからGoogleカレンダーに転記するLambda関数 #1

AWS Lambda から Power Automate の Teams Incoming Webhook コネクタの挙動をテストする

# はじめに

Microsoft (以下MS) が、Teams内のOffice 365コネクタを廃止することを発表しました。

これにはIncoming Webhookも含まれ、記事執筆時点では、以下のスケジュールが設定されています。* 2024年8月15日: 新規コネクタの作成が停止し、これ以降、新規にIncoming Webhookを利用する場合、Power Automateのワークフローでコネクタを介して受信する方式に対応する必要あり

* 2024年12月31日: 既存のWebhook URLが無効化される予定 (ただし、URLを更新すれば2025年12月まで利用可能)最新の情報は、以下のMS公式サイトをご参考ください。

AWSユーザーも、**[AWS Health Aware](https://aws.amazon.com/jp/blogs/news/aws

AWS-Parameters-and-Secrets-Lambda-Extensionを試す

## 背景

Lambda上でSSMパラメータストアの値を都度取得するのが嫌で調べてたら以下を見つけたので試して見るhttps://docs.aws.amazon.com/ja_jp/secretsmanager/latest/userguide/retrieving-secrets_lambda.html#retrieving-secrets_lambda_env-var

* Lambda Layer は以下を指定

`arn:aws:lambda:ap-northeast-1:133490724326:layer:AWS-Parameters-and-Secrets-Lambda-Extension-Arm64:11`## コード

“` typescript:index.mjs

import {SSMClient, GetParameterCommand} from ‘@aws-sdk/client-ssm’;export const handler = async () => {

const path = “/hoge/secure/params”;

AWS API GatewayでLambdaプロキシ統合を設定する方法

AWS API Gatewayを使用してLambda関数をプロキシ統合する際に、正しいレスポンス形式を使用しないと500エラーが発生することがあります。

本記事では、Rubyで書かれたLambda関数を使用して、正しいレスポンス形式を返す方法について説明します。# Lambdaプロキシ統合とは

Lambdaプロキシ統合は、API Gatewayが受け取ったリクエストをそのままLambda関数に渡し、Lambda関数からのレスポンスをそのままクライアントに返すシンプルな統合方法です。

この統合方法を使用することで、リクエストやレスポンスのマッピング設定を簡略化できます。# 正しいレスポンス形式

Lambdaプロキシ統合を使用する場合、Lambda関数は以下の形式でレスポンスを返す必要があります:

“`json

{

“statusCode”: 200,

“headers”: {

“Content-Type”: “application/json”

},

“body”: “{\”message\”:\”success\”}”

}

“`bodyフィールド

AWS Lambda上で「LINE Messaging API SDK for Python」を使ったコードをデプロイしてLINE Botを作ることを楽しむ

# はじめに

LINEの[Messaging API](https://developers.line.biz/ja/services/messaging-api/)を使ってオウム返しをするボットを作ります。

こちらの記事をとても参考にしています。ありがとうございます。

https://qiita.com/w2or3w/items/1b80bfbae59fe19e2015

LINEボットはWebhookを受け取って反応するものを作ればよいので、[Amazon API Gateway](https://aws.amazon.com/jp/api-gateway/)と[AWS Lambda](https://aws.amazon.com/jp/lambda/)の組み合わせでサクッと作れます。

大部分はさきほど紹介した上記記事をなぞってもらえばできます。

この記事では、[LINE Messaging API SDK for Python](https://github.com/line/line-bot-sdk-python)を[AWS Lambda](https://aws.am

Lineでよさそうな部屋を紹介してくれるボットを作成する

# 借りる部屋を簡単に探したい

部屋を借りるときにSuumoなどのサイトを使って部屋を検索することができる。しかし、以下の理由により既存のサイトでは使いにくさを感じた。

・同じ物件を複数の不動産屋が掲載していて省きたい

・検索結果の情報量が多いので必要な情報だけを一覧で確認したい

・検索条件がある程度固定されている中(1人暮らし、家族向けなど)で物件同士を比較したい

・電車の中などで短時間で手軽に物件検索したいそこで、これらの課題を解決するアプリを開発した。

# Lineで簡単に良さそうな物件を紹介してくれるボットの作成

Suumoから自分の探したい条件の物件を簡単に比較できるようなLineボットを作成した。

自分の探したい物件の情報としては、「神奈川県の北東寄り」「間取りは2LDK以上」、「家賃は15万円以下」などがあり、こちらに該当する物件が今回借りたい部屋の条件である。

また、物件同士で比較したい条件は「家賃」、「敷金/礼金」、「間取り」などがある。

詳しい検索条件、比較内容については以降で記載する。

以下完成したLineボットで物件について検索している画面である。

駅名や

AWS LambdaでSupabaseを使用したらNo module named ‘pydantic_core._pydantic_core’が出た時の対処

## 問題

AWS LambdaでPythonからSupabaseを使用しようとしたら,

“`エラー

No module named ‘pydantic_core._pydantic_core

“`

と表示された.## 原因

Supabaseで使用されているfastapiのバージョンが高すぎると動作しない様子.## 解決策

fastapiのバージョンを下げてインストールした後に,Supabaseモジュールをインストールする.

“`

pip install -t ./python fastapi==0.99 supabase

“`

ここではfastapiのバージョンを0.99に指定している.

タグベースによるEC2インスタンスの夜間停止によるコスト削減

https://github.com/koishitori/Lambda_function_EC2InsetanceChangeState

# 背景このAWS Lambda関数は、タグ値で制御してEC2インスタンスの起動や停止を行うことができます。EventBridgeを使用した夜間の定期停止や、AWS Change Calendarを利用した不定期な長期停止など、様々なシナリオで活用できる汎用的なEC2インスタンス管理ツールです。Spotインスタンスの停止ができるようになったので、さらなるコスト削減のために作りました。

## 実行環境

### エンジン

Python3.12

### 環境

Lambda## 関数の概要

この関数は以下の構造のJSONペイロードを受け取ります:

“`json

{

“region”: string, # 対象リージョン

“tagName”: string, # 対象EC2インスタンスのタグ名

“action”: string, # start(起動)またはstop(停止)

“test”: bool # テスト

akippaの予約CSVからGoogleカレンダーに転記するLambda関数 #2

バックオフィスが生成AIでがんばるシリーズです。今回はプライベートで利用している[akippa](https://www.akippa.com/)の予約情報取得からGoogleカレンダー転記の自動化についてやっていきます。

1回目は[こちら](https://qiita.com/norifumiishii/items/c618547e49d7e97a1bde)

# Lambdaにレイヤーを準備する

今回GoogleカレンダーAPIを使用するのにあたり、Google系のライブラリをレイヤーで使用します。

ちなみに私LambdaでPythonを使用する際にライブラリはレイヤー機能で使用するというのを初めて知りました。

Windows11でPowershellを使用してレイヤーに使用するzipファイルを作成していきます。

1. 作業用ディレクトリを作成します

“`shell

mkdir lambda_project

cd lambda_project

“`

1. 仮想環境を作成して有効化する

“`sh

python -m venv ven

AWS Lambdaで翻訳APIを作成するハンズオンをやってみた

# はじめに

SAAの勉強で知ったサービスを実際に触って学習内容の定着を図りたいという目的でハンズオンをやってみました。

参考にしたハンズオンの動画、資料は大変わかりやすかったのですが、動画が作成された段階でのコンソール画面と2024年8月時点でのコンソールが若干違っていたため少しわかりづらかったです…。

作業メモとしてこちらの記事を作成してみました。以下のリンクから日本語でのAWSハンズオンや資料一覧を確認できます。

https://aws-samples.github.io/jp-contents-hub/# AWS Lambda ハンズオン

今回参考にしたハンズオンはこちらです。

https://pages.awscloud.com/JAPAN-event-OE-Hands-on-for-Beginners-Serverless-1-2022-reg-event.html?trk=aws_introduction_page# 使用するAWSのサービス

今回使用するAWSのサービスは以下の通りです

– [AWS Lambda](https://aws.amazo

「RDSデータを長期的に格納」RDSからS3にスナップショットを自動的に輸出

RDSでスナップショットが最大35日間保存できます。長期間保存するためには、S3にエクスポートする必要があります。ただし、これはAWSコンソールでの手動機能に制限されています。この記事では、自動エクスポート方法について説明します。

# 1.前提

事前に以下のサービスを用意しておきます。

* Mysqlインスタントが立ち上がる(DBエンジンが任意)

* S3バケットが立ち上がる(デフォルト設定)本記事で“`rds-snapshot-archive-test“`というS3バケットを用意ました。

# 2.構築・流れ

1. RDS自体でスナップショットを撮影した時にSNSトピックにイベント送信

2. SNSはラムダ処理にトリガー

3. ラムダはRDSでS3輸出処理コマンド

Backlog Gitリポジトリの更新をトリガーに、Amazon S3にコンテンツを自動でアップロードする

# はじめに

## この記事の概要

この記事では、タスク管理ツールBacklogのGitリポジトリとAmazon S3(以下、S3)との連携方法についてまとめています。

流れとしては、Backlog GitリポジトリのWebフックを使用して、リポジトリの更新をトリガーにLambda関数が実行されるようにします。そして、Lambda関数がS3にファイルアップロード処理を行います。

この一連の流れの具体的な構築方法や注意点をまとめています。## BacklogのGit機能について

[Backlog](https://backlog.com/)はタスク管理ツールです。そして、その機能の一つにGit機能があります。

ソースコード管理といえば、IT業界全体では、おそらくGitHubを使用しているチーム(人)が多いと思いますが、タスク管理にBacklogを使用しているケースでは、タスクとソースコードの紐付けが行いやすかったり、タスク管理とソースコード管理(他にもWiki機能もあるのでドキュメント管理なども)を一元化できるなどのメリットがあります。このGit機能は基本的には特に不自由な

AWS CDKでCloudfront – Lambda FunctionURLsのOACを定義する

## 以前の記事

https://qiita.com/Kanahiro/items/85573c9ae724df435a6a

## TL;DR

“`typescript

import * as iam from ‘aws-cdk-lib/aws-iam’;

import * as cloudfront from ‘aws-cdk-lib/aws-cloudfront’;

import * as lambda from ‘aws-cdk-lib/aws-lambda’;// 以下のようなリソースが定義されているとして(当然このままでは動かない)

const distribution = new cloudfront.Distribution({hoge:fuga});

const lambdaFunc = new lambda.DockerImageFunction({{hoge:fuga}};

const funcUrl = lambdaFunc.addFunctionUrl({

authType: lambda.FunctionUrlAuthType.AWS_IA

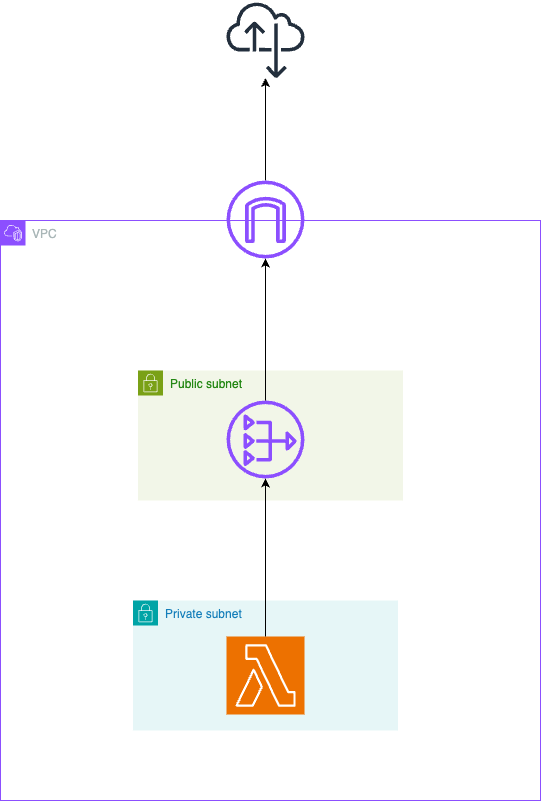

VPCを設定したLambdaからインターネットにアクセスしたい

# 要約

① NATゲートウェイを設置したパブリックサブネットを用意する

② NATゲートウェイにルーティングさせるルートテーブルを設定したプライベートサブネットを用意する

③ Lmabdaに②で作成したプライベートサブネットを指定する# 図解

Lambdaは、デフォルトの設定ではAWSが自動で設定したVPCに設置され、自由にインターネットへのアクセスができます。

ただし、なんらかの事情で(例えばVPC内のリソースにLambdaからアクセスしたい時など)自分のVPCにLambdaを設置したい場合は、

図のようにNATゲートウェイを経由してインターネットにアクセスする必要があります。

# なぜNATを経由する必要があるのか

例えば、以下のようにパブリックサブネットに直接Lambdaを設置してインターネットにアクセス

Autonomous Database:S3にファイルがアップロードされたらすぐに表にロードし、ロード完了後にS3上のファイルを削除する

# はじめに

[こちらの記事](https://qiita.com/500InternalServerError/items/fac9e8d5d7638a4a4020)の応用編として、Amazon S3バケットにファイルがアップロードされたら、それをトリガーにしてLambdaファンクションが起動、起動したLambdaファンクションがAutonomous Databaseに接続してアップロードされたファイルを表にロードし、ロード後にロードしたファイルをAmazon S3から削除する仕組みを構築してみました。

処理の流れのイメージは以下のようになります。

1. Amazon S3のバケットにファイルをアップロード

2. Amazon S3バケットのオブジェクト作成イベントをLambdaに通知

3. LambdaからAutonomous Databaseにアクセス

4. Amazon S3にアップロードされたファイルを表にロードし、ロード後にファイルを削除するPL/SQLプロシージャをLambdaから実行

5. PL/SQLプロシージャによって、Amazon S3にアップロード

【AWS SAM】入門してみた dockerで環境構築 ruby

# はじめに

今までserverless frame workを使用して、lambdaのデプロイを行ってきたのですが、serverless frame work V4から有料化ということを受けてSAMへ移行したいと思いました。https://dev.classmethod.jp/articles/sls-migrate-cdk-or-sam/

# 環境構築

dockerで行いました。

* ruby3.3.4

* node 20.16.0

* aws-sam-cliをzipで公式ページから取得しインストールhttps://github.com/yuuki4135/sam-test-app

“`dockerfile

FROM ruby:3.3.4-slim-bookwormRUN useradd -u 1000 developper \

&& apt-get update -qq && apt-get install -qq –no-install-recommends \

curl awscli unzip wget git vimRUN wget h

Python lambdaで一行関数を書く時のコツ

## はじめに

Pythonのlambda式は、簡潔で読みやすい一行関数を作成するための強力なツールです。本記事では、lambdaを使って効果的な一行関数を書くためのコツをいくつか紹介します。

## 1. シンプルさを保つ

lambdaは単純な操作に最適です。複雑な処理は通常の関数で行いましょう。

“`python

# Good

square = lambda x: x**2

print(square(5)) # 出力: 25# Not so good (複雑すぎる)

complicated = lambda x, y: [i for i in range(x) if i % y == 0]

print(complicated(10, 3)) # 出力: [0, 3, 6, 9]

“`## 2. 読みやすさを優先する

Lambda関数で日本語ファイルを処理する際にエラーが出た

# はじめに

Lambda関数でAWS CLIコマンドを使用して、日本語ファイル名のファイルをS3にアップロードしようとしたところ、エラーが出ました。

“`

‘utf-8’ codec can’t encode characters in …

“`Lambda関数のランタイムは `Node.js20.x (OS: Amazon Linux 2023)` です。

# エラーの原因

まずは、環境変数設定で `LANG` に `ja_JP.utf8` を設定してみますが、結果は変わらず。

Amazon Linux 2023のDockerコンテナを起動して確認してみると、そもそもデフォルトで日本語のロケールデータが存在していませんでした。

“`bash

$ docker run

Lambda関数でAWS CLIを使用する

# はじめに

この記事では、AWS LambdaでAWS CLIを使用する手順についてまとめています。

# 対応方法

AWS Lambdaでは、ファイル書き込みが許可されているのは `/tmp` 配下のみです。

これはつまり、AWS Lambdaで実行するプログラムからはパッケージのインストールは行えないということを意味します。そのため、対応方法としては、デプロイパッケージにまとめてしまうか、Lambdaレイヤーを使用するかになるかと思います。

今回の私のケースでは、AWS CLIは他の関数でも使用する可能性があることなどを踏まえて、Lambdaレイヤーを使用することにしました。

Lambdaレイヤーについての詳細な説明は、[AWS公式ドキュメント](https://docs.aws.amazon.com/ja_jp/lambda/latest/dg/chapter-layers.html)に譲ります。# 対応手順

全体の流れとしては、Lambda関数で使用するOSのDockerコンテナでAWS CLIのzipファイルを作成し、そのzipファイルでLambdaレイヤー

AWS CDKを用いてRemixアプリケーションをLambdaにデプロイする

## はじめに

この記事は[こちらの記事](https://qiita.com/monjara/items/9aad76d22a70557a8a6a)の内容をAWS CDKに置き換えたものです。

cdkプロジェクトはTypeScriptで作成しています。完成品はこちらのリポジトリにあります。

https://github.com/monjara/remix-cdk-lambda-example

## 必要なもの

– CDK CLI

– Node.js

– Docker## 階層構造

以下のような階層でプロジェクトを作成します。

“`sh

.

├── remix-app/ # Remixのアプリケーション

│ ├── (Remixのファイル群)

│ ├── Dockerfile # buildしたアプリケーションを実行するためのDockerfile

│ └── run.sh # remix-serveを実行するスクリプト

└── cdk/ # CDKのプロジェクト

“`## Remixプロジェクトのセットアップ

“`sh

npx create-r

akippaの予約CSVからGoogleカレンダーに転記するLambda関数 #1

バックオフィスが生成AIでがんばるシリーズですが、今回はプライベートで利用しているサービスの自動化についてやっていきます。

# やりたいこと

[akippa(アキッパ)](https://www.akippa.com/)の駐車場予約情報CSVをオーナーサイトからダウンロードして予約情報をGoogleカレンダーに転記します。# 方針

以下の処理を行うAWSのLambda関数を作成して実現させます。

1. akippaのオーナーサイトにログインします

1. 予約一覧のページにあるCSVダウンロードのリンクから予約一覧CSVをダウンロードします

1. CSVから1行ごとの予約情報をパースして、Googleカレンダーに Google calendar API を使用して転記しますなおコードをクリーンにするため、akippaオーナーサイトのログイン情報(ID/Pass)及びGoogleカレンダーIDやAPIのトークン(JSON)はLambda関数の環境変数に保存します。

今回コードはChatGPT 4o に作成させ、テストしながらデバッグしていきました。

# Googleカレンダーの準備