- 1. EC2からS3へのアップロードやダウンロードの方法

- 2. S3のデータをAzure上で動くSnowflakeに取り込んでみた!

- 3. AWS Console-to-Code使用してみた

- 4. 【AWS初心者必見!】S3バケットのデータを守るための完全ガイド

- 5. CloudWatch Logs Insightsまとめ

- 6. GASからAWS APIを実行する

- 7. ChatGPT 4oと対話しながらwebサービスを個人開発する話 その③

- 8. AWS MLAベータ試験受験レポート

- 9. 【AWS】小学生でもわかる!サイバー攻撃から守るサービス(WAF, Shield, Firewall Manager)を徹底解説【擬人化】

- 10. 【備忘用】S3バケットの指定した箇所のオブジェクト数と総容量を表示させるCLIコマンド

- 11. 別アカウントのLamdbaをinvokeする際の注意点

- 12. Lambda(Node.js)のDockerイメージをデプロイしてみた。(その2,Node.jsのイメージ作成)

- 13. ApacheにBasic認証かけるの、意外と簡単なのよ

- 14. DDoS攻撃対策におけるAWS Shield Advancedの活用

- 15. GitHub Universe 2024 現地会場!! GitHub カンファレンスレポート at サンフランシスコ [2024/11/29~2023/11/30]

- 16. 【AWSをこれから学びたい人へ】無料でAWSについて学べるAWS Cloud Quest ~AWS100本ノック~ 12/100

- 17. Private Subnet に構築した EC2 インスタンス(Amazon Linux 2023)に接続する方法

- 18. AWS re:Inventに行く前に〜国際カンファレンスに行く前に気をつけたいこと〜

- 19. Ubuntu で Kubeadm により k8s 環境構築実験(2)

- 20. 【Terraform】AWS S3リファクタリング

EC2からS3へのアップロードやダウンロードの方法

## はじめに

S3を経由してEC2から別のEC2へファイルを移動する機会がありましたので、自分の備忘録を兼ねて記載します。

※本記事は2024年10月ごろの情報を基に作成しています。

## 実施したいこと

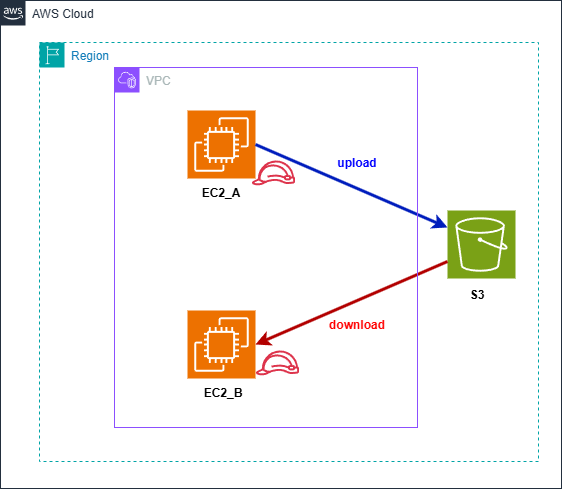

「EC2_A」のファイルをS3経由して「EC2_B」にコピーします。

構成は以下のようになります

## 前提

・AWSアカウントがあること

・EC2、S3のリソースが既にあること

・EC2、S3の操作権限があること

・EC2にSSHで接続できると

・EC2にAWS CLIがインストールされていること

・ターミナルはTeraTarmを使用## 作業内容

①EC2_AとEC2_BにS3のアクセス権限を付与(IAMロールのアタッチ)

②EC2_AらS3へアップロード

③S3からEC2_Bへダウンロード

④EC2_AとE

S3のデータをAzure上で動くSnowflakeに取り込んでみた!

# やってみたこと

Amazon S3のデータを

Microsoft Azure上で動くSnowflakeに取り込めるのか検証しました## 検証のきっかけ

Snowflakeへデータを取り込む場合はS3などのデータレイクを使う事が一般的かと思います。

Snowflakeへのデータ取り込みを考える中で、例えばAmazon S3のデータをSnowflakeに取り込みたい場合はAWS上で動くSnowflakeでないといけないのでは?という疑問が生まれました。## ドキュメントによると

> Snowflakeは、Snowflakeアカウントのクラウドプラットフォームに関係なく、

次のいずれかの場所にステージングされたファイルからのデータのロードをサポートしています。https://docs.snowflake.com/ja/user-guide/intro-cloud-platforms

ドキュメントよりSnowflakeアカウントとデータレイクのサービスは関係ないとのことですが、この目で確かめてみたいので検証してみます!

# 検証内容

**Amazon S3** に格納さ

AWS Console-to-Code使用してみた

## はじめに

AWSから、AWS Console-to-Code を正式リリースされました。

この機能を使えば、AWSコンソールで行った操作をCloudFormationやAWS CDKのコードに変換でき、Infrastructure as Code (IaC) の実現に役立ちます。詳しくはこちら:

https://aws.amazon.com/jp/blogs/news/convert-aws-console-actions-to-reusable-code-with-aws-console-to-code-now-generally-available/

## AWS Console-to-Codeの概要

AWS Console-to-Codeは、AWSコンソール上の操作をリアルタイムで記録し、その操作に対応するコード(CLIコマンド、CloudFormation、CDKなど)を生成する機能です。

これにより、手動のコンソール操作から自動化のコード生成まで、効率よくコード化することが可能になります。### 対応しているAWSサービス

現在、Console-to-Cod

【AWS初心者必見!】S3バケットのデータを守るための完全ガイド

## はじめに

こんにちは、uiroleです!AWSの**Amazon S3**は、高い可用性とスケーラビリティを持つオブジェクトストレージサービスとして広く利用されていますが、セキュリティ設定が不十分だと、大量のデータが外部に漏洩するリスクがあります。

今回は、AWS S3のセキュリティを高めるためのベストプラクティスと設定方法について解説します。

### 対象者

– S3バケットを使用しているAWSユーザー

– AWS環境のセキュリティ強化を目指すシステム管理者やエンジニア

– S3データのセキュリティリスクを回避したい人### 前提

– AWSの基本操作ができる

– IAM(Identity and Access Management)の基本的な概念を理解している### 記事を読んで解決すること

– S3のセキュリティリスクとその対策を理解できる

– IAMポリシーやバケットポリシー、暗号化などの設定方法を実践できる

– S3を安全に利用するためのベストプラクティスを学べる## S3のセキュリティリスクと課題

Amazon S3は利便性が高い反面、以下の

CloudWatch Logs Insightsまとめ

## はじめに

CloudWatch Logs Insightsを使用するときに意識しておかないと、思ったよりコスト高くなるので、クエリの書き方と実行時に注意することをまとめる。

## クエリ実行時に注意すること

公式にも掲載されているが、クエリ実行時はロググループを選択すること、時間指定は必ず行うこと。

個人的にはFiledsも指定した方がパフォーマンス上がるので、Mustレベルで指定した方がいいと思う。ウィジェットは慣れるまで使用しない方が安心。更新のたびにクエリ実行されるので、頻繁に更新されるとコスト嵩む。

## 生成されるフィールド

| filed | 内容 |

| — | — |

| @message | ログイベント |

| @timestamp | ログイベントに含まれる時刻 |

| @ingestionTime | CloudWatchがイベントを受信した時刻 |

| @logStream | イベントを追加したログストリーム名 |

| @log | ロググループの識別子(account_id:log-group-name) |## クエリ構文

GASからAWS APIを実行する

# はじめに

GAS(Google Apps Script)便利ですよね。

簡単に実行環境が整備出来て、その他のGoogleサービスとの相性も良いです。またAWSの環境を導入している人も多いのではないでしょうか?

EC2やLambdaなど便利なサービスも多く、安定していて使い勝手が良いです。今日はGASからAWSのAPI操作をするための下記のライブラリの使い方を紹介します。

[GitHub – smithy545/aws-apps-scripts: An interface to authenticate AWS api requests from within google scripts](https://github.com/smithy545/aws-apps-scripts)

# 使い方

## 前提

下記の条件が必要です。

– Googleアカウント持っていてGASが実行できる

– AWSアカウント持ってる

– AWSでアクセスキーの発行をしているアクセスキーはIAMの画面から発行できるのでまだの人は事前に行ってください。

私はAWS CLI用に発行したもの

ChatGPT 4oと対話しながらwebサービスを個人開発する話 その③

これまでの記事でChatGPTと対話しながらWebサービスを開発する様子を掲載してきました。今回は、そこで開発したWebサービスに関する記事を紹介します。

開発したwebサービスは「みんなのナビ」というマニュアルを作成し、共有するサービスになります。

https://manualshare.net

↓以前の記事

https://qiita.com/travelclass0606/items/fceb85872620a418e8ab

https://qiita.com/travelclass0606/items/c38d042520e134ddcd57

# きっかけ

妻の実家に行った際、義母が大阪万博でブース鑑賞の申請をWebで行うのにとても苦労している様子を見て、誰かがわかりやすいマニュアルを作成し、共有できるサービスがあれば助かると感じた。# ベース作り

まずは、ベースとなる部分をChatGPTに作成してもらいました。個人開発では、初期設定をChatGPTにさくっと作成してもらうことで、効率よく進められるのでおすすめです。以下のプロンプトをChatGPTに入力しました

AWS MLAベータ試験受験レポート

# はじめに

この記事では、AWS Certified Machine Learning – Specialty (MLS-C01) 試験のベータ版を受験した際の勉強方法や所感を共有します。AWS Certified AI Practitioner (AIF) の情報については、[前回の記事](https://qiita.com/ry-harada/items/0b902bdb96ec24d2fcab)をご覧ください。# 受験背景

(AIFの受験動機と同じになります)

昨年度、AWS認定全冠を達成し、「2024 Japan AWS All Certifications Engineers」を受賞しました。今年度、新たに3つの認定試験(DEA/AIF/MLS-C01)が追加され、来年のAll Certにはこれらの認定も必要になると予想し、早期受験を決意しました。さらに、AIの分野の盛り上がりに合わせ、個人的な知識習得の目標もありました。そして、ベータ試験に合格すると、AWS AI Dayで特別なステッカーがもらえるという情報も、受験のモチベーションとなりました。https://a

【AWS】小学生でもわかる!サイバー攻撃から守るサービス(WAF, Shield, Firewall Manager)を徹底解説【擬人化】

:::note warn

「AWSに親しみを持つエンジニアが1人でも増えてほしい」という思いを込めて、擬人化で説明してます。

「ちょっとノリが合わないな…」と思ったら、戻るボタンで回れ右してね 😉

:::## はじめに

こんにちは!

この文章では、AWS(アマゾン・ウェブ・サービス)が提供するセキュリティサービスを、擬人化して楽しく紹介するよ。AWSは、インターネットを通じていろんなサービスを提供する会社だけど、そのサービスを安全に守るために、たくさんの頼もしい仲間たちが頑張っているんだ。セキュリティって聞くと難しそうだけど、実は彼らもみんな個性的で面白いキャラクターなんだ。たとえば、セキュリティを守るために一生懸命働く**AWS WAF**や、悪質な攻撃から私たちを守ってくれる**AWS Shield**など、彼らの役割や特徴をわかりやすく説明していくよ。

[2.前提条件](#2-前提条件)

[3.CLIコマンド](#3-CLIコマンド)

[4.まとめ](#4-まとめ)# 1. はじめに

ELBのログを確認したときに、S3にしこたま圧縮格納されているオブジェクトを見て、これどのくらいのオブジェクトあってどのくらいの容量なのかなぁとAthena試算用で出したかったのです。今後も使うだろうけど、メモがてら記事にしようかなと思った次第でございます!

もっといいやり方ある場合はご教授いただけるとしっぽブンブンです。

よろしくお願いいたします!!!!# 2. 前提条件

特になし

→今回は表示させてテキスト出力くらいなので、Cloud shellでいいかなぁと

権限の関係でCloudshell使えないとかの場合はAWS CLIインストールしたサーバにCLI打てるように権限追加等して環境を整えてください。

今回の説明からは省きます。# 3. CLIコマンド

母体はこれです。

“`CLI:AWS CLI

aws s3api list-objects-v2 \

–bucket バケ

別アカウントのLamdbaをinvokeする際の注意点

## やりたいこと

今回はECSから別アカウントのLambdaをinvokeする際に少し沼ったので注意点を挙げたと思います!## やり方

### 権限の設定#### 1. 呼び出し先のLambdaでの設定

**Lambdaのアクセス許可ポリシーの追加**

– Lambda関数に対して呼び出し元のアカウントから呼び出しを許可するためのリソースベースのポリシーを設定します。(Lambdaの実行ロールなどはいじる必要はありません!)

– AWS CLIでする場合は以下のコマンドを参考にしてください!“`bash

aws lambda add-permission \

–function-name my-function \

–statement-id AllowInvokeFromAccount \

–action lambda:InvokeFunction \

–principal arn:aws:iam:::root

“`– `my-func

Lambda(Node.js)のDockerイメージをデプロイしてみた。(その2,Node.jsのイメージ作成)

# はじめに

LambdaをDockerイメージでデプロイする方法を、調査する機会があったので自分の備忘用にメモ書きを残します。今回は、デプロイ用のNodeイメージを用意する所をメモ書きします。

Dockerファイルの記載方法がハマりどころでした。

# EC2に、Node.jsの環境を用意する

+ コンパイル環境の用意

+ gitの用意

+ nvmのインストール

+ nvmを使ってNode.jsをインストール“`shell

sudo yum update

sudo yum -y install gcc-c++

sudo yum -y install git

git clone https://github.com/creationix/nvm.git ~/.nvm

“`「.bash_profile」を書き換えて、ログイン時にNVMの情報を読み込むようにする。

“`shell

# nvm

if [[ -s ~/.nvm/nvm.sh ]] ; then

source ~/.nvm/nvm.sh ;

fi

“`

を末尾に追記する。端末(Ter

ApacheにBasic認証かけるの、意外と簡単なのよ

## まえがき

Basic認証かけるのは意外と簡単!!

## 前提

Linux上でmod_wsgiつかって動かしてるPython Webアプリケーションであること

今回のケースではEC2上でApache HTTPを動かしている。## 1. htpasswdツールをインストール

#### 1-a.そもそもhttpd-toolsが入ってるか確認

“`

rpm -q httpd-tools

“`

・入っていない場合: 以下のような文言を吐く

package httpd-tools is not installed・入っている場合: 以下のような文言を吐く

httpd-tools-2.4.59-2.amzn2023.x86_64#### 1-b.入ってなかったらインストール

“`

sudo yum install httpd

DDoS攻撃対策におけるAWS Shield Advancedの活用

# 概要

DDoS攻撃対策に特化したマネージドサービス「AWS Shield Advanced」の概要、機能、料金について詳しく説明します。

## DDoS攻撃の現状

DDoS(Distributed Denial of Service)攻撃は、複数のリソースからターゲットに過剰な負荷をかけ、サービスを不能にすることを目的としています。最近のデータによると、DDoS攻撃の件数は毎年100万件以上で、特にアプリケーションレイヤーの攻撃が増加しています。

## AWS Shieldの2つのサービス

### Shield Standard

Shield Standardは、全てのインターネットに面したAWSのサービスに自動的に適用され、ネットワークレイヤーとトランスポートレイヤーの攻撃を緩和します。特に設定は不要で、追加料金も発生しません。

### Shield Advanced

Shield Advancedは、12ヶ月のサブスクリプション料金がかかる有料サービスで、お客様固有のリソースをDDoS攻撃から保護します。具体的な機能としては、DDoS攻撃の可視化、緩和機能、専門

GitHub Universe 2024 現地会場!! GitHub カンファレンスレポート at サンフランシスコ [2024/11/29~2023/11/30]

株式会社エムニ・Software enginnerのmatsudoです。

明日からサンフランシスコで`Github Universe 2024`が開かれますhttps://reg.githubuniverse.com/flow/github/universe24/attendee-portal/page/livestream?tab.day=20241029

今年は、10th anniversaryということで、かなり2023年から予告してたのもあり港を1つ貸し切る規模で行われ会場は、`Fort Mason Center for Arts & Culture`というゴールデンゲートブリッジがよく見える場所で行われるみたいです。

去年とは違い、Ticketがプラスチックになっていました。(去年は紙だった)

– バスは平気で遅れるので日本の感覚で信頼してはいけない。

– 歩くと昼間の大通りでもボッタクリをする奴らがたくさんいる。謎のサインを高額で売りつけられる等の被害が多数あり,銃社会なので逆らうと危険。

– **マスク**をつけていると日本人 or 台湾人と思われてカモにされるのでやめよう—

## 何を着ていくべきか

日本人でアニメ好きならアニメTシャツを着ていくと話しかけられるかも

—

## 持っていくべきもの

– 日本のお菓子(意外と喜ばれる)

– 水着: プールがついていたりするので

– 飲料水: 買うと高いので何本か持っていこう

– かばんやキャリーケースにはAir Tagなどをつけておく—

## 事前準備

– 人気の講座はすぐ埋まるので早めに予約しておく

Ubuntu で Kubeadm により k8s 環境構築実験(2)

[Ubuntu で Kubeadm により k8s 環境構築実験(1)](https://qiita.com/intrajp/items/483fe317c5e89b5e99e9)からの続きです。

これまでで、kubernetes のコントロールプレーンの初期化には成功しているはずです。

To start using your cluster, you need to run the following as a regular user:

クラスターを始めるには、一般ユーザーで、次のコマンドを実行する必要があります。

“`

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

“`

さて、クラスターに Pod network を追加する必要があります。

“`

kubectl apply -f [podnetwork].yaml

“`

これらのうちから選びます。

“`

【Terraform】AWS S3リファクタリング

# はじめに

Qiitaの上手な書き方がわからないpiromoです。TerraformもAWSもS3も「???」ですが、仕事でS3のリファクタリングをするというタスクがあったので、以下備忘録です。今回のタスクで0.000001mmだけTerraformが分かった気がします。嘘です。# 概要

Terraform のAWSプロバイダーのバージョンをすでにv4以上に引き上げている環境で、以下のようなエラーが出力されていました。しばらくそのままにしていましたが、将来的にS3のリファクタリングは必須なので、今回泣きながらリファクタリングを進めました。“`

╷

│ Error: Argument is deprecated

│

│ with aws_s3_bucket.this,

│ on main.tf line 50, in resource “aws_s3_bucket” “log”:

│ 19: resource “aws_s3_bucket” “log” {

│

│ Use the aws_s3_bucket_lifecycle_configuration r